В этом уроке вы узнаете:

- Что такое CrewAI и чем она отличается от других библиотек агентов ИИ.

- Его основные ограничения и способы их преодоления с помощью рабочего процесса RAG.

- Как интегрировать его с API для скраппинга, чтобы предоставить агентам искусственного интеллекта данные SERP для более точных ответов.

Давайте погрузимся!

Что такое CrewAI?

CrewAI – это Python-фреймворк с открытым исходным кодом для оркестровки и управления автономными агентами ИИ, которые совместно выполняют сложные задачи. В отличие от одноагентных систем, таких как Browser Use, CrewAI строится вокруг “экипажей”, которые представляют собой набор агентов.

В команде каждый агент имеет определенную роль, цель и набор инструментов. Вы можете оснастить агентов ИИ специальными инструментами для выполнения таких специализированных задач, как поиск информации в Интернете, подключение к базам данных и т. д. Такой подход открывает возможности для специализированного решения задач с помощью ИИ и принятия эффективных решений.

Мультиагентная архитектура CrewAI способствует эффективности и масштабируемости. Регулярно добавляются новые функции, такие как поддержка моделей Qwen и параллельных вызовов функций, что делает эту экосистему быстро развивающейся.

Ограничения CrewAI и способы их преодоления с помощью свежих веб-данных

CrewAI – это многофункциональный фреймворк для создания мультиагентных систем. Однако он унаследовал некоторые ключевые ограничения от LLM, на которые он опирается. Поскольку LLM обычно предварительно обучаются на статичных наборах данных, им не хватает осведомленности в реальном времени, и они обычно не могут получить доступ к последним новостям или живому веб-контенту.

Это может привести к устаревшим ответам или, что еще хуже, к галлюцинациям. Эти проблемы особенно вероятны, если агенты не ограничены и не обеспечены актуальными, достоверными данными в системе поиска и дополненной генерации.

Чтобы устранить эти ограничения, вы должны снабжать агентов (и, соответственно, их LLM) надежными внешними данными. Веб – самый полный и динамичный источник данных, поэтому он является идеальной целью. Поэтому одним из эффективных подходов является предоставление агентам CrewAI возможности выполнять поисковые запросы в реальном времени на таких платформах, как Google или другие поисковые системы.

Это можно сделать, создав собственный инструмент CrewAI, позволяющий агентам извлекать релевантные веб-страницы для обучения. Однако поиск SERP (Search Engine Results Pages) технически сложен из-за необходимости рендеринга JavaScript, решения CAPTCHA, ротации IP-адресов и постоянно меняющейся структуры сайтов.

Управление всем этим собственными силами может оказаться сложнее, чем разработка логики CrewAI. Лучшим решением является использование высококлассных API для соскабливания SERP, таких как SERP API от Bright Data. Эти сервисы выполняют тяжелую работу по извлечению чистых, структурированных данных из Интернета.

Интегрировав такие API в рабочий процесс CrewAI, ваши агенты получат доступ к свежей и точной информации без лишних операционных затрат. Эту же стратегию можно применить и к другим доменам, подключив агентов к специфическим для домена API для сбора информации.

Как интегрировать CrewAI с API SERP для доступа к данным в режиме реального времени

В этом разделе вы узнаете, как предоставить агенту искусственного интеллекта, созданному с помощью CrewAI, возможность получать данные непосредственно из систем SERP с помощью Bright Data SERP API.

Интеграция с RAG позволяет вашим агентам CrewAI предоставлять более контекстные и актуальные результаты, дополненные реальными ссылками для дальнейшего чтения.

Выполните следующие шаги, чтобы создать суперкоманду с помощью интеграции SERP API от Bright Data!

Пререквизиты

Чтобы следовать этому руководству, убедитесь, что у вас есть:

- Ключ API Bright Data.

- API-ключ для подключения к LLM (в этом руководстве мы будем использовать Gemini).

- Локально установленный Python 3.10 или выше.

Более подробную информацию можно найти на странице установки в документации CrewAI, которая содержит актуальные предварительные условия.

Не волнуйтесь, если у вас еще нет ключа API Bright Data, так как в следующих шагах вы получите инструкции по его созданию. Что касается ключа API LLM, если у вас его нет, мы рекомендуем создать ключ API Gemini, следуя официальному руководству Google.

Шаг #1: Установите CrewAI

Начните с глобальной установки CrewAI, выполнив следующую команду в терминале:

pip install crewaiПримечание: При этом будет загружено и настроено несколько пакетов, поэтому это может занять некоторое время.

Если у вас возникли проблемы при установке или использовании, обратитесь к разделу по устранению неполадок в официальной документации.

После установки вы получите доступ к команде crewai CLI. Проверьте это, выполнив в терминале следующее:

crewaiВы должны увидеть вывод, похожий на этот:

Usage: crewai [OPTIONS] COMMAND [ARGS]...

Top-level command group for crewai.

Options:

--version Show the version and exit.

--help Show this message and exit.

Commands:

chat Start a conversation with the Crew, collecting...

create Create a new crew, or flow.

deploy Deploy the Crew CLI group.

flow Flow related commands.

install Install the Crew.

log-tasks-outputs Retrieve your latest crew.kickoff() task outputs.

login Sign Up/Login to CrewAI+.

replay Replay the crew execution from a specific task.

reset-memories Reset the crew memories (long, short, entity,...

run Run the Crew.

signup Sign Up/Login to CrewAI+.

test Test the crew and evaluate the results.

tool Tool Repository related commands.

train Train the crew.

update Update the pyproject.toml of the Crew project to use...

version Show the installed version of crewai.Отлично! Теперь у вас есть CrewAI CLI, готовый к инициализации вашего проекта.

Шаг №2: Настройка проекта

Выполните следующую команду, чтобы создать новый проект CrewAI под названием serp_agent:

crewai create crew serp_agentВо время настройки вам будет предложено выбрать предпочтительного поставщика услуг LLM:

Select a provider to set up:

1. openai

2. anthropic

3. gemini

4. nvidia_nim

5. groq

6. huggingface

7. ollama

8. watson

9. bedrock

10. azure

11. cerebras

12. sambanova

13. other

q. Quit

Enter the number of your choice or 'q' to quit:В данном случае мы выберем вариант “3” для Gemini, так как его интеграция через API бесплатна.

Затем выберите конкретную модель Gemini, которую вы хотите использовать:

Select a model to use for Gemini:

1. gemini/gemini-1.5-flash

2. gemini/gemini-1.5-pro

3. gemini/gemini-2.0-flash-lite-001

4. gemini/gemini-2.0-flash-001

5. gemini/gemini-2.0-flash-thinking-exp-01-21

6. gemini/gemini-2.5-flash-preview-04-17

7. gemini/gemini-2.5-pro-exp-03-25

8. gemini/gemini-gemma-2-9b-it

9. gemini/gemini-gemma-2-27b-it

10. gemini/gemma-3-1b-it

11. gemini/gemma-3-4b-it

12. gemini/gemma-3-12b-it

13. gemini/gemma-3-27b-it

q. QuitВ данном примере достаточно бесплатной модели gemini/gemini-1.5-flash. Поэтому вы можете выбрать вариант “1”.

Затем вам будет предложено ввести свой API-ключ Gemini:

Enter your GEMINI API key from https://ai.dev/apikey (press Enter to skip):Вставьте его и, если все идет как надо, вы должны увидеть такой результат:

API keys and model saved to .env file

Selected model: gemini/gemini-1.5-flash

- Created serp_agent.gitignore

- Created serp_agentpyproject.toml

- Created serp_agentREADME.md

- Created serp_agentknowledgeuser_preference.txt

- Created serp_agentsrcserp_agent__init__.py

- Created serp_agentsrcserp_agentmain.py

- Created serp_agentsrcserp_agentcrew.py

- Created serp_agentsrcserp_agenttoolscustom_tool.py

- Created serp_agentsrcserp_agenttools__init__.py

- Created serp_agentsrcserp_agentconfigagents.yaml

- Created serp_agentsrcserp_agentconfigtasks.yaml

Crew serp_agent created successfully!В результате этой процедуры будет создана следующая структура проекта:

serp_agent/

├── .gitignore

├── pyproject.toml

├── README.md

├── .env

├── knowledge/

├── tests/

└── src/

└── serp_agent/

├── __init__.py

├── main.py

├── crew.py

├── tools/

│ ├── custom_tool.py

│ └── __init__.py

└── config/

├── agents.yaml

└── tasks.yamlВот:

main.py– это главная точка входа в ваш проект.- В файле

crew.pyвы определяете логику команды. config/agents.yamlопределяет агентов искусственного интеллекта.config/tasks.yamlопределяет задачи, которые будут выполнять ваши агенты.tools/custom_tool.pyпозволит вам добавлять пользовательские инструменты, которые могут использовать ваши агенты.- В

.envхранятся ключи API и другие переменные окружения.

Перейдите в папку проекта и установите зависимости CrewAI:

cd serp_agent

crewai installПоследняя команда создаст локальную виртуальную среду .venv в каталоге проекта. Это позволит вам запускать CrewAI локально.

Отлично! Теперь у вас есть полностью инициализированный проект CrewAI, использующий Gemini API. Вы готовы к созданию и запуску своего интеллектуального агента SERP.

Шаг № 3: Начало работы с SERP API

Как уже говорилось, мы будем использовать SERP API Bright Data для получения контента со страниц результатов поисковых систем и передачи его нашим агентам CrewAI. В частности, мы будем выполнять точный поиск в Google на основе данных пользователя и использовать полученные данные для улучшения ответов агента.

Чтобы настроить SERP API, вы можете обратиться к официальной документации. В качестве альтернативы выполните следующие шаги.

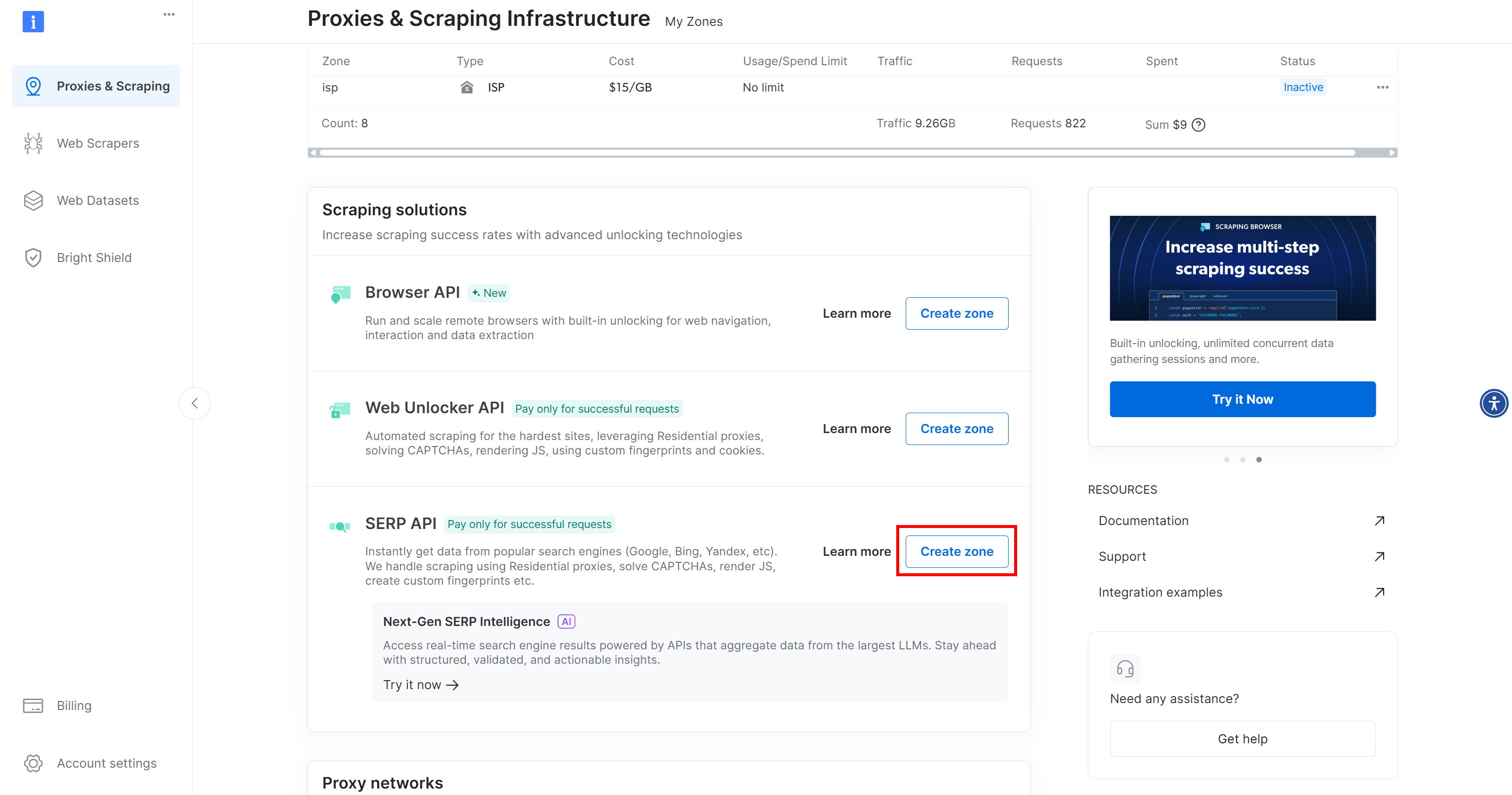

Если вы еще не сделали этого, зарегистрируйте учетную запись на сайте Bright Data. В противном случае просто войдите в систему. Войдя в систему, перейдите в раздел “Мои зоны” и нажмите на строку “SERP API”:

Если вы не видите этой строки в таблице, значит, вы еще не настроили зону SERP API. В этом случае прокрутите страницу вниз и нажмите на кнопку “Создать зону” в разделе “SERP API”:

На странице продукта SERP API переключите переключатель “Активировать”, чтобы включить продукт:

Далее следуйте официальному руководству, чтобы сгенерировать ключ API Bright Data. Затем добавьте его в файл .env, как показано ниже:

BRIGHT_DATA_API_KEY=<YOUR_BRIGHT_DATA_API_KEY>Замените на фактическое значение ключа API Bright Data.

Вот оно! Теперь вы можете использовать SERP API от Bright Data в своей интеграции с CrewAI.

Шаг #4: Создание инструмента поиска по СЕРПам CrewAI

Пора определить инструмент поиска SERP, который ваши агенты смогут использовать для взаимодействия с Bright Data SERP API и получения данных о результатах поиска.

Для этого откройте файл custom_tool.py в папке tools/ и замените его содержимое на следующее:

# src/search_agent/tools/custom_tool.py

import os

import json

from typing import Type

import requests

from pydantic import BaseModel, PrivateAttr

from crewai.tools import BaseTool

class SerpSearchToolInput(BaseModel):

query: str

class SerpSearchTool(BaseTool):

_api_key: str = PrivateAttr()

name: str = "Bright Data SERP Search Tool"

description: str = """

Uses Bright Data's SERP API to retrieve real-time Google search results based on the user's query.

This tool fetches organic search listings to support agent responses with live data.

"""

args_schema: Type[BaseModel] = SerpSearchToolInput

def __init__(self, **kwargs):

super().__init__(**kwargs)

# Read the Bright Data API key from the envs

self._api_key = os.environ.get("BRIGHT_DATA_API_KEY")

if not self._api_key:

raise ValueError("Missing Bright Data API key. Please set BRIGHT_DATA_API_KEY in your .env file")

def _run(self, query: str) -> str:

url = "https://api.brightdata.com/request"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {self._api_key}"

}

payload = {

"zone": "serp", # Replace with the name of your actual Bright Data SERP API zone

"format": "json",

"url": f"https://www.google.com/search?q={query}&brd_json=1"

}

try:

response = requests.post(url, json=payload, headers=headers)

# Raise exceptions in case of errors

response.raise_for_status()

# Parse the JSON response

json_response = response.json()

response_body = json.loads(json_response.get("body", "{}"))

if "organic" not in response_body:

return "The response did not include organic search results."

# Return the SERP data as a JSON string

return json.dumps(response_body["organic"], indent=4)

except requests.exceptions.HTTPError as http_err:

return f"HTTP error occurred while querying Bright Data SERP API: {http_err}"

except requests.exceptions.RequestException as req_err:

return f"Network error occurred while connecting to Bright Data: {req_err}"

except (json.JSONDecodeError, KeyError) as parse_err:

return f"Error parsing Bright Data SERP API response: {parse_err}"Этот инструмент CrewAI определяет функцию, которая принимает запрос пользователя и получает результаты SERP из Bright Data SERP API с помощью реквестов.

Обратите внимание, что если используется параметр запроса brd_json=1 и формат установлен на json, SERP API отвечает с такой структурой:

{

"status_code": 200,

"headers": {

"content-type": "application/json",

// omitted for brevity...

},

"body": "{"general":{"search_engine":"google","query":"pizza","results_cnt":1980000000, ...}}"

}В частности, после разбора поля body, которое содержит строку JSON, вы получите следующую структуру данных:

{

"general": {

"search_engine": "google",

"query": "pizza",

"results_cnt": 1980000000,

"search_time": 0.57,

"language": "en",

"mobile": false,

"basic_view": false,

"search_type": "text",

"page_title": "pizza - Google Search",

"timestamp": "2023-06-30T08:58:41.786Z"

},

"input": {

"original_url": "https://www.google.com/search?q=pizza&brd_json=1",

"request_id": "hl_1a1be908_i00lwqqxt1"

},

"organic": [

{

"link": "https://www.pizzahut.com/",

"display_link": "https://www.pizzahut.com",

"title": "Pizza Hut | Delivery & Carryout - No One OutPizzas The Hut!",

"rank": 1,

"global_rank": 1

},

{

"link": "https://www.dominos.com/en/",

"display_link": "https://www.dominos.com",

"title": "Domino's: Pizza Delivery & Carryout, Pasta, Chicken & More",

"description": "Order pizza, pasta, sandwiches & more online...",

"rank": 2,

"global_rank": 3

},

// ...additional organic results omitted for brevity

]

}Итак, вас в основном интересует органическое поле. Это поле, к которому обращаются в коде, которое разбирается в строку JSON и затем возвращается инструментом.

Потрясающе! Теперь ваш агент CrewAI может использовать этот инструмент для получения свежих данных SERP.

Шаг #5: Определите агентов

Для выполнения этой задачи вам понадобятся два агента CrewAI, каждый из которых имеет свою цель:

- Исследователь: Собирает результаты поиска в Google и фильтрует полезные сведения.

- Аналитик по составлению отчетов: Собирает результаты исследования в структурированное и удобочитаемое резюме.

Вы можете определить их в файле agents.yml, заполнив его следующим образом:

# src/search_agent/configs/agents.yml

researcher:

role: >

Online Research Specialist

goal: >

Conduct smart Google searches and collect relevant, trustworthy details from the top results.

backstory: >

You have a knack for phrasing search queries that deliver the most accurate and insightful content.

Your expertise lies in quickly identifying high-quality information from reputable sources.

reporting_analyst:

role: >

Strategic Report Creator

goal: >

Organize collected data into a clear, informative narrative that’s easy to understand and act on.

backstory: >

You excel at digesting raw information and turning it into meaningful analysis. Your work helps

teams make sense of data by presenting it in a well-structured and strategic format.Обратите внимание, как эта конфигурация отражает то, что должен делать каждый агент – ни больше, ни меньше. Просто определите их роль, цель и предысторию. Очень хорошо!

Шаг#6: Укажите задачи для каждого агента

Приготовьтесь к определению конкретных задач, которые четко определяют роль каждого агента в рабочем процессе. Согласно документации CrewAI, для достижения точных результатовопределение задачи важнее определения агента.

Таким образом, в файле tasks.yml вам нужно указать агентам, что именно они должны делать, как показано ниже:

# src/search_agent/configs/tasks.yml

research_task:

description: >

Leverage SerpSearchTool to perform a targeted search based on the user's {query}.

Build API parameters like:

- 'query': develop a short, Google-like, keyword-optimized search phrase for search engines.

From the returned data, identify the most relevant and factual content.

expected_output: >

A file containing well-structured raw JSON content with the data from search results.

Avoid rewriting, summarizing, or modifying any content.

agent: researcher

output_file: output/serp_data.json

report_task:

description: >

Turn the collected data into a digestible, insight-rich report.

Address the user's {query} with fact-based findings. Add links for further reading. Do not fabricate or guess any information.

expected_output: >

A Markdown report with key takeaways and meaningful insights.

Keep the content brief and clearly, visually structured.

agent: reporting_analyst

context: [research_task]

output_file: output/report.mdВ этом случае вы определяете две задачи – по одной для каждого агента:

research_task: Рассказывает исследователю, как использовать Bright Data SERP API с помощью инструмента, в том числе как динамически создавать параметры API на основе запроса.report_task: Указывает, что конечным результатом должен быть читабельный, информативный отчет, построенный строго на основе собранных данных.

Это определение tasks.yml – все, что нужно вашим агентам CrewAI для сбора данных SERP и создания отчета, основанного на реальных результатах поиска.

Пора интегрировать агентов CrewAI в свой код и дать им возможность работать!

Шаг #7: Создайте команду

Теперь, когда все компоненты на месте, соедините все в файле crew.py, чтобы создать полностью функциональный экипаж. В частности, вот как вы можете определить свой crew.py:

# src/search_agent/crew.py

from crewai import Agent, Crew, Process, Task

from crewai.project import CrewBase, agent, crew, task

from .tools.custom_tool import SerpSearchTool

from crewai.agents.agent_builder.base_agent import BaseAgent

from typing import List

@CrewBase

class SerpAgent():

"""SerpAgent crew"""

agents: List[BaseAgent]

tasks: List[Task]

@agent

def researcher(self) -> Agent:

return Agent(

config=self.agents_config["researcher"],

tools=[SerpSearchTool()],

verbose=True

)

@agent

def reporting_analyst(self) -> Agent:

return Agent(

config=self.agents_config["reporting_analyst"],

verbose=True

)

@task

def research_task(self) -> Task:

return Task(

config=self.tasks_config["research_task"],

output_file="output/serp_data.json"

)

@task

def report_task(self) -> Task:

return Task(

config=self.tasks_config["report_task"],

output_file="output/report.md"

)

@crew

def crew(self) -> Crew:

"""Creates the SerpAgent crew"""

return Crew(

agents=self.agents,

tasks=self.tasks,

process=Process.sequential,

verbose=True,

)В crew.py вам нужно использовать декораторы CrewAI(@agent, @task, @crew, в данном случае), чтобы связать логику из ваших YAML-файлов и подключить фактическую функциональность.

В данном примере:

Агент-исследовательполучает доступ кинструменту SerpSearchTool, позволяющему ему выполнять реальные поисковые запросы Google с помощью SERP API компании Bright Data.- Агент

reporting_analystнастроен на создание итогового отчета, используя результаты работы исследователя. - Каждая задача соответствует тому, что было определено в файле

tasks.yml, и явно привязана к соответствующему выходному файлу. - Процесс настроен на

последовательность, что гарантирует, что сначала будет запущенисследователь, а затем его данные будут переданыreporting_analyst.

Начали! Теперь ваша команда SerpAgent готова к выполнению задания.

Шаг #8: Создание главного цикла

В файле main.py запустите команду, передав ей на вход запрос пользователя:

# src/search_crew/main.py

import os

from serp_agent.crew import SerpAgent

# Create the output/ folder if it doesn"t already exist

os.makedirs("output", exist_ok=True)

def run():

try:

# Read the user's input and pass it to the crew

inputs = {"query": input("nSearch for: ").strip()}

# Start the SERP agent crew

result = SerpAgent().crew().kickoff(

inputs=inputs

)

return result

except Exception as e:

print(f"An error occurred: {str(e)}")

if __name__ == "__main__":

run()Миссия завершена! Ваша интеграция CrewAI + SERP API (с использованием Gemini в качестве LLM) теперь полностью функциональна. Просто запустите main.py, введите поисковый запрос и наблюдайте, как команда собирает и анализирует данные SERP для создания отчета.

Шаг № 9: Запустите агента искусственного интеллекта

В папке проекта запустите приложение CrewAI с помощью следующей команды:

crewai runТеперь введите такой запрос, как:

"What are the new AI protocols?"Это тот вопрос, на который типичный LLM может затрудниться дать точный ответ. Причина в том, что большинство новейших протоколов ИИ, таких как CMP, A2A, AGP и ACP, не существовало на момент первоначального обучения модели.

Вот что произойдет в деталях:

Как вы можете заметить выше, CrewAI обрабатывает запрос именно таким образом:

- Выполняется

исследовательскийагент, который:- Преобразует введенные пользователем данные в структурированный запрос

"новые протоколы искусственного интеллекта". - Отправляет запрос в SERP API Bright Data через

SerpSearchTool. - Получает результаты от API и сохраняет их в файл

output/serp_data.json.

- Преобразует введенные пользователем данные в структурированный запрос

- Затем запускается агент

reporting_analyst, который:- Считывает структурированные данные из файла

serp_data.json. - Используйте эту свежую информацию для создания контекстно-зависимого отчета в формате Markdown.

- Сохраняет окончательный структурированный отчет в файл

output/report.md.

- Считывает структурированные данные из файла

Если вы откроете файл report.md с помощью программы просмотра Markdown, вы увидите примерно следующее:

В отчет включена соответствующая контекстная информация и даже ссылки, которые помогут вам углубиться.

И вуаля! Вы только что реализовали рабочий процесс RAG в CrewAI с помощью интеграции с SERP API.

Следующие шаги

Встроенный в Crew инструмент Bright Data SERP API позволяет агентам получать свежие результаты поисковых систем. Получив URL-адреса этих SERP, вы можете использовать их для вызова других API для извлечения необработанного контента со страниц, на которые ведут ссылки – либо в необработанном виде(для преобразования в Markdown и отправки агенту), либо уже разобранным в JSON.

Эта идея позволяет агентам автоматически находить надежные источники и получать из них актуальную информацию. Кроме того, можно интегрировать такое решение, как Agent Browser, чтобы позволить агентам динамически взаимодействовать с любой живой веб-страницей.

Это лишь несколько примеров, но потенциальные сценарии и варианты использования практически безграничны.

Заключение

В этом блоге вы узнали, как сделать агентов CrewAI более контекстно-ориентированными, интегрировав настройку RAG с помощью SERP API от Bright Data.

Как уже говорилось, это лишь одна из многих возможностей, которые вы можете использовать, подключив своих агентов к внешним API для сбора информации или инструментам автоматизации. В частности, решения Bright Data могут служить мощными строительными блоками для интеллектуальных рабочих процессов ИИ.

Усовершенствуйте свою инфраструктуру искусственного интеллекта с помощью инструментов Bright Data:

- Автономные агенты искусственного интеллекта: Поиск, доступ и взаимодействие с любыми веб-сайтами в режиме реального времени с помощью мощного набора API.

- Вертикальные приложения искусственного интеллекта: создавайте надежные пользовательские конвейеры данных для извлечения веб-данных из отраслевых источников.

- Базовые модели: Доступ к совместимым наборам данных веб-масштаба для предварительного обучения, оценки и тонкой настройки.

- Мультимодальный ИИ: воспользуйтесь крупнейшим в мире хранилищем изображений, видео и аудио, оптимизированных для ИИ.

- Поставщики данных: Подключайтесь к надежным поставщикам, чтобы получать высококачественные, готовые к искусственному интеллекту наборы данных в масштабе.

- Пакеты данных: Получайте курируемые, готовые к использованию, структурированные, обогащенные и аннотированные наборы данных.

Для получения дополнительной информации изучите наш центр искусственного интеллекта.

Создайте учетную запись Bright Data и попробуйте все наши продукты и услуги для разработки агентов искусственного интеллекта!