Эта подробная статья будет посвящена следующим темам:

- Определение инструмента веб-парсинга

- На что следует обратить внимание при сравнении лучших инструментов для парсинга

- Какие инструменты веб-парсинга самые лучшие

Давайте рассмотрим эти вопросы подробнее!

Что такое инструмент веб-парсинга?

Инструмент веб-парсинга — это библиотека, программа или служба, упрощающая автоматическое извлечение данных с сайта. Другими словами, она упрощает веб-парсинг.

Поскольку компании знают, насколько ценны данные в наши дни, они стремятся защитить их, даже если они являются общедоступными на сайтах этих компаний. Они просто не хотят раздавать их бесплатно. Вот почему все больше и больше сайтов используют решения защиты от парсинга. Некоторые наиболее эффективных из них, о которых вам следует знать, — это капчи, проверка цифровых отпечатков и ограничение скорости.

Если не принять должные меры по обходу данных решений, они могут легко помешать вашей деятельности по сбору данных. Одна из главных целей инструментов веб-парсинга — снижение эффективности этих защитных решений. В частности, такие инструменты предоставляют вам все необходимое для беспроблемного сбора данных с сайта.

Пора назвать лучшие инструменты веб-парсинга, но сначала давайте разберемся, как происходит отбор этих лучших инструментов.

Аспекты, которые следует учитывать при оценке лучших инструментов веб-парсинга

Вот наиболее важные аспекты, на которые нужно обращать внимание при сравнении лучших инструментов веб-парсинга:

- Плюсы и минусы: основные преимущества и недостатки анализируемого инструмента парсинга.

- Функции: список возможностей инструмента.

- Стоимость: какая цена у самого простого платного плана инструмента для парсинга

- Основная цель: краткое описание полезных свойств инструмента.

- Платформы: для каких операционных систем доступен инструмент.

- Отзывы: оценка отзывов пользователей об этом инструменте на таких сайтах, как Capterra.

- Интеграции: с какими технологиями, инструментами и языками программирования они могут работать.

Теперь давайте взглянем на список лучших доступных библиотек, технологий и инструментов для парсинга!

11 лучших инструментов веб-парсинга

Узнайте, какие инструменты лучше всего подходят для сбора данных из Интернета и почему они попали в этот список.

1. Bright Data

Компания Bright Data занимает лидирующие позиции в индустрии сбора веб-данных, управляя обширной и разнообразной сетью прокси-серверов по всему миру. Сеть компании насчитывает миллионы резидентных прокси-серверов, которые идеально подходят для реализации стратегий ротации IP-адресов, необходимых для эффективного веб-парсинга.

На базе этой инфраструктуры Bright Data предлагает множество инструментов и служб веб-парсинга, включая API для Web Scraper. Этот облачный инструмент позволяет получить доступ к настраиваемым конечным точкам API, предназначенным для извлечения веб-данных из популярных доменов и отвечающим сложным потребностям проектов по сбору данных.

API для Web Scraper разработаны для обеспечения масштабируемости и надежности и устранения распространенных технических препятствий, возникающих при веб-парсинге, таких как преодоление антибот-механизмов.

Поэтому такие API становятся предпочтительным решением для сбора данных для организаций, которые стремятся усовершенствовать свои инициативы, основанные на данных. При этом они снижают эксплуатационные расходы и повышают эффективность сбора данных в Интернете.

- Ротация IP-адресов через прокси-серверы

- Автоматическое решение капчей

- Ротация пользовательских агентов

- Возможности рендеринга JavaScript

- Экспорт данных в удобочитаемые форматы

Другими словами, Scraper API предлагает наибольшее количество возможностей из числа других лучших инструментов веб-парсинга в рамках одной службы. Это делает его идеальным решением для обхода проблем парсинга, снижения общих затрат и экономии времени.

- Время безотказной работы: 99,9%

- Неограниченное масштабирование

- На 100% соответствует требованиям и этике

- Поддержка людьми 24/7

👎

- Не бесплатный

Цены зависят от количества записей и типа домена. От 0,001 $.

Доступна бесплатная пробная версия.

🛠️

- Пакетная обработка запросов

- Готовые к использованию конечные точки API

- Масштабируемая инфраструктура

- Обнаружение данных

- Автоматический парсинг

- Валидация данных

- Автоматическая ротация IP-адресов

- Настраиваемые заголовки

- Решение капчи

- Рендеринг JavaScript

- Ротация пользовательского агента

- Резидентные прокси-серверы

- Доставка веб-хуков

💻

⚙️

- Любой язык программирования, поддерживающий веб-разработку (например, JavaScript, Python, Java, Rust, Go, C# и т. д.)

- Любой HTTP-клиент

- Любая библиотека для парсинга

2. ScrapingBee

ScrapingBee предлагает API для веб-парсинга премиум-класса, упрощающий извлечение данных из Интернета. В частности, этот API управляет прокси-серверами и конфигурацией headless-браузера, чтобы вы могли сосредоточиться на извлечении данных. Целевая аудитория — разработчики, которые интегрируют конечную точку парсинга в свои скрипты. Этот API основан на большом пуле прокси-серверов, позволяющих обойти ограничения скорости и снизить вероятность блокировки.

- Вы будете платить только за успешные запросы

- Обширная документация и множество сообщений в блогах

- Конечная точка парсинга с простой настройкой

- Множество функций

- Эффективен на большинстве сайтов

👎

- Не самый быстрый API для парсинга

- Ограниченное распараллеливание

- Требуются технические знания

🛠️

- Поддержка интерактивных веб-сайтов, требующих выполнения JavaScript

- Автоматический обход антиботов, включая решение капчи

- Настраиваемые заголовки и файлы cookie

- Геотаргетинг

- Перехваты запросов XHR/AJAX

- Экспорт данных в HTML, JSON, XML и др.

- Планирование вызовов API для парсинга

💻

💬

⚙️

- Любой HTTP-клиент

- Любая библиотека для веб-парсинга

3. Octoparse

Octoparse — один из лучших инструментов веб-парсинга в категории без программирования. Он предоставляет собой программу для парсинга, которая может извлекать неструктурированные данные с любого сайта и преобразовывать их в структурированные наборы данных. Определение задач извлечения данных основано на простом интерфейсе «укажи и нажми», предназначенном для пользователей без технических знаний.

- Инструмент для парсинга без программирования

- Множество интеграций

- Бесплатный план и бесплатная пробная версия расширенных функций

- Документация и справочный центр на нескольких языках, включая испанский, китайский, французский и итальянский

- Поддержка OpenAPI

- Преодолевает за вас трудности при парсинге

👎

- Нет поддержки Linux

- Некоторые функции сложны для понимания

🛠️

- Возможности автоматического циклирования

- Множество шаблонов для парсинга данных с популярных сайтов

- Помощник по веб-парсингу на базе ИИ

- Облачная автоматизация 24/7 для планирования работы парсеров

- Решение проблем с ротацией IP-адресов и капчей

- Авторотация IP-адресов и решение капчи

- Поддержка бесконечной прокрутки, разбиения на страницы, выпадающего списка, наведения курсора и имитации многих других действий

💰

💬

⚙️

- Zapier

- Google Диск

- Google Таблицы

- Поставщики настраиваемых прокси-серверов

- Cloudmersive API

- Airtable

- Dropbox

- Slack

- Hubspot

- Salesforce

4. ScraperAPI

ScraperAPI — это инструмент веб-парсинга, позволяющий получать HTML-код любой веб-страницы, даже если она снабжена защитой от парсинга. Благодаря усовершенствованной системе обнаружения и обхода ботов он может подключаться к большинству сайтов и предотвращать блокировку запросов. Этот API для парсинга гарантирует неограниченную пропускную способность для быстрых веб-сканеров.

- Обширная документация на нескольких языках программирования

- Более 10 тыс. клиентов

- Бесплатные вебинары, тематические исследования и ресурсы для начала работы с инструментом

- Неограниченная пропускная способность

- Гарантия безотказной работы 99,9%

- Профессиональная поддержка

👎

- Геотаргетинг по всему миру доступен только с планом Business

- Требуются технические знания

🛠️

- Возможности рендеринга JavaScript

- Поддержка прокси-серверов премиум-класса

- Функция авто-парсинга JSON

- Умная ротация прокси-серверов

- Настраиваемые заголовки

- Автоматический повтор попыток

- Поддержка пользовательских сеансов

- Обход капчи и антиботов

💻

💬

⚙️

- Любой HTTP-клиент

- Любая библиотека для веб-парсинга

5. Playwright

Playwright — одна из лучших библиотек для headless-браузеров. Она поддерживается Microsoft и получила более чем 60 тысячами звезд на GitHub!

Playwright предоставляет комплексный API для тестирования E2E и веб-парсинга. В частности, он снабжен многофункциональным интерфейсом для беспрепятственного управления браузерами и имитации взаимодействия пользователей с веб-страницами. Это идеальный инструмент для сбора данных с сайтов с динамическим контентом, использующих JavaScript для рендеринга или извлечения данных. Особенность Playwright — его постоянный многоязычный, мультибраузерный и кроссплатформенный характер.

Узнайте про него в действии из нашей статьи с инструкциями по веб-парсингу с помощью Playwright.

- В настоящее время это инструмент автоматизации браузера с наибольшим количеством функций

- Разработан и поддерживается Microsoft

- Кроссплатформенный, мультибраузерный и многоязычный

- Современный, быстрый и эффективный инструмент

- Впечатляющее количество функций, включая автоматическое ожидание, визуальную отладку, повторные попытки, настраиваемые отчеты и многое другое

- Интуитивный и совместимый с языком API

👎

- Непростая настройка

- Освоение всех его функций требует времени

💰

💻

🛠️

- Имитация взаимодействия с веб-браузером, включая навигацию, заполнение форм и извлечение данных

- API для нажатия, ввода текста, заполнения форм и многого другого

- Поддержка headed- и headless режимов (с пользовательским интерфейсом и без него)

- Встроенная поддержка параллельного выполнения тестов в нескольких экземплярах браузера

- Встроенные возможности отладки

- Встроенные репортеры

- API с автоматическим ожиданием

⚙️

- JavaScript и TypeScript

- Java

- .NET

- Python

- Chrome, Edge, браузеры на базе Chromium, Firefox, Safari, браузеры на базе WebKit

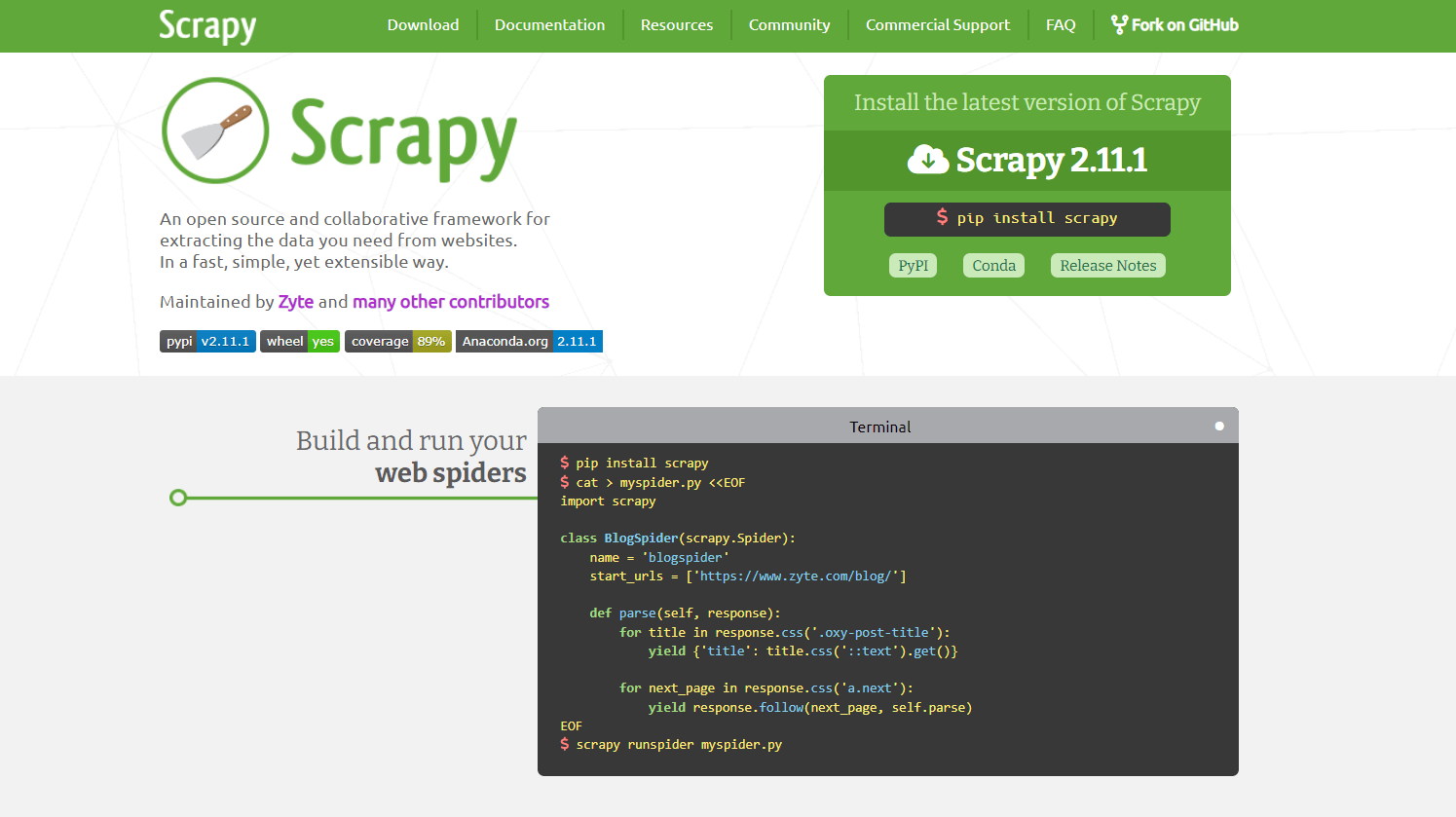

6. Scrapy

Scrapy — это фреймворк с открытым исходным кодом и комплексным API для веб-парсинга и веб-сканирования на Python. Она позволяет определять автоматизированные и эффективные задачи для сканирования сайтов и извлечения структурированных данных с их страниц.

Узнайте, как его использовать, из нашего руководства по сканированию веб-страниц на Python с помощью Scrapy.

👍 Плюсы:

- Высокоскоростной фреймворк для сканирования и парсинга

- Отлично подходит для крупномасштабного извлечения данных

- Эффективное использование памяти

- Широкие возможности настройки

- Расширяется с помощью промежуточного программного обеспечения

- Удобный процесс веб-парсинга

👎

- Для парсинга взаимодействующих сайтов требуется интеграция Splash

- Нет встроенных возможностей автоматизации браузера

- Крутая кривая обучения

🛠️

- Поддержка селекторов CSS и выражений XPath

- Встроенный HTML-парсер

- Встроенный HTTP-клиент

- Логика автоматического сканирования

- Парсинг JSON

💰

💻

💬

⚙️

- Python

- Splash

7. Apify

Apify — это платформа для развертывания задач по парсингу. Она предлагает тысячи готовых веб-парсеров, а также работает с пользовательскими скриптами на Python и JavaScript. Платформа Apify позволяет превратить любой веб-сайт в API и надежно извлекать из него данные в любом масштабе. Apify — команда разработчиков Crawlee, популярной библиотеки Node.js для веб-парсинга.

- Бесплатные курсы, академии и учебные пособия по веб-парсингу

- Обширная документация

- Встроенный пул прокси-серверов

- Множество интеграций

- Более 1,5 тысяч готовых шаблонов веб-парсеров

- Нам доверяют многие известные партнеры

👎

- Не самая лучшая служба поддержки

- Ограниченное распараллеливание

🛠️

- Умная ротация IP-адресов

- Автоматическое создание цифровых отпечатков браузера, похожих на создаваемые человеком

- Настраиваемые файлы cookie и заголовки

- Встроенный набор инструментов для обхода антиботов

- Интеграция с Python и JavaScript, включая Playwright, Puppeteer, Selenium и Scrapy

🎯

💻

⚙️

- Любая библиотека для веб-парсинга

- Google Диск

- Asana

- GitHub

- Slack

- Gmail

- Zapier

8. ParseHub

ParseHub — это ПК-приложение для веб-парсинга, не требующее программирования и позволяющее извлекать данные с сайта через интерфейс типа «укажи и нажми». С помощью этого инструмента веб-парсинга можно определить всю задачу извлечения данных за три шага:

- Перейдите на нужные страницы во встроенном браузере

- Нажмите мышью на элементы для извлечения данных и укажите, какие данные извлекать

- Экспортируйте данные, полученные при парсинге, в удобочитаемые форматы, такие как CSV или JSON.

👍 Плюсы:

- Определение задачи веб-парсинга без программирования

- Кроссплатформенность

- Интуитивный пользовательский интерфейс и опыт пользователя

- Простая облачная интеграция

👎

- Высокая нагрузка на процессор

- Не подходит для крупномасштабных операций

🛠️

- Запланированные запуски

- Автоматическая ротация IP-адресов

- Поддержка интерактивных веб-сайтов

- Поддержка условных и иных выражений

- Поддержка селекторов XPath, RegEx и CSS

- Автоматическое извлечение данных из таблиц

- Извлечение данных из текста узла и HTML-атрибутов

- REST API и веб-хуки

💰

💻

💬

⚙️

- Облачная платформа ParseHub для хранения данных

- HTTP-клиенты через API ParseHub REST

- Dropbox

- Хранилище Amazon S3

9. Import.io

Import.io — облачная платформа, цель которой — упрощение преобразования полуструктурированной информации, содержащейся на веб-страницах, в структурированные данные. Эти данные можно использовать для любых целей: от принятия бизнес-решений до интеграции других платформ с помощью REST API. Пользователи могут визуально определять действия по веб-парсингу прямо на сайте import.io без необходимости установки ПК-приложения.

👍 Плюсы:

- Нет необходимости использовать ПК-приложения и не требуется дополнительная установка

- Мощные возможности управления данными

- Интуитивный пользовательский интерфейс

- Эффективна на крупных сайтах

👎

- Запутанная документация

- Намного дороже среднего уровня

🛠️

- Интеграция с прокси-серверами премиум-класса

- Экстракторы данных для конкретных стран

- Автоматическое распознавание капчи

- Уведомления по эл. почте

- Планирование задач

- Автоматическая обработка разбиения на страницы

💰

💻

⚙️

- Большинство библиотек для парсинга

- Возможности обработки данных

- Программный экспорт данных через API

- Экспорт данных в нескольких форматах

10. WebScraper.io

WebScraper.io — это простой инструмент для извлечения данных типа «укажи и нажми». Он предлагается в виде расширения для браузера Chrome. Он дает пользователям возможность извлекать данные вручную или автоматически прямо в браузере. Эти задачи по извлечению данных также можно выполнять в облаке. Функицонал продукта довольно ограничен, и он не располагает всеми функциями других лучших инструментов веб-парсинга. Однако он отлично подходит для удовлетворения базовых потребностей и быстрого парсинга данных.

- Визуальный выбор HTML-элементов

- Удобный интерфейс

- Отлично подходит для базовых нужд

👎

- Очень ограниченное распараллеливание

- Базовая поддержка по эл. почте

- Работает только в Chrome

- Ограниченное хранение данных в облаке

- Ограниченные возможности удовлетворения продвинутых потребностей

🛠️

- Экспорт в формате CSV, XLSX, JSON

- Планировщик заданий по парсингу

- Интеграция с прокси-серверами

- Возможности парсинга типа «укажи и нажми» в браузере

- Выполнение задач парсинга как локально, так и в облаке

💻

⚙️

- Chrome

- Dropbox

- Google Таблицы

- Google Диск

- Amazon S3

11. Data Miner

DataMiner предоставляет расширение для веб-парсинга в Google Chrome под названием Data Scraper. Оно позволяет извлекать данные с веб-страниц прямо в браузере и экспортировать их в CSV-файлы.

- Бесплатные сеансы поддержки в реальном времени

- Простой интерфейс

- Ограниченная поддержка по электронной почте

- Доступно только для Chrome

- Ограниченные возможности выполнения сложных задач извлечения данных

- Платное продвинутое обучение

🛠️

- Автоматизация сканирования

- Поддержка пользовательских скриптов Javascript

- Работает на всех доменах

- Загрузка изображений

- Поддержка действий нажатия и прокрутки

💻

⚙️

- Google Таблицы

Лучшие инструменты веб-парсинга: сводная таблица

Если вам нужна краткая информация о лучших инструментах веб-парсинга, ознакомьтесь со следующей таблицей:

Заключение

В этом руководстве вы рассмотрели некоторые из лучших инструментов веб-парсинга для сбора онлайн-данных с сайтов. В наиболее эффективных конфигурациях обычно используется несколько упомянутых здесь инструментов. Например, инструмент автоматизации браузера, такой как Playwright, можно интегрировать с антидетект-браузером. Он, в свою очередь, может интегрироваться с прокси-сервером. Довольно сложно, не правда ли?

Выберите простой путь и попробуйте Scraper API. Это универсальный полнофункциональный API для парсинга данных нового поколения, который предоставляет все необходимое для извлечения онлайн-данных и обхода антибот-технологий. Парсинг данных еще никогда не был таким простым!

Зарегистрируйтесь сейчас и поговорите с одним из наших экспертов по данным о решениях для парсинга, которые мы предлагаем.

Кредитная карта не требуется