В этой статье мы узнаем о:

- С какими проблемами сталкиваются разработчики, когда данные, взятые с веб-сайтов, ненадежны или устарели.

- Определим причины плохих результатов скрапинга

- Получим рекомендации по обеспечению более чистых и надежных данных.

Давайте погрузимся!

Некоторые причины неточности данных Веб-скрейпинга

Прежде чем узнать о том, как повысить точность полученных данных, вам нужно знать некоторые причины этих проблем. В этом разделе вы узнаете о некоторых проблемах, с которыми вы можете столкнуться при скрапинге. Некоторые из них – это динамический контент, частые изменения DOM и т. д.

JavaScript-рендеринг контента, создающий пробелы в данных

Веб-сайты с большим количеством JavaScript загружают контент асинхронно после первоначального HTML-ответа, в результате чего традиционные HTTP-скраперы получают неполную структуру страницы. Когда вы запрашиваете страницу, вы получаете только начальный HTML-скелет до выполнения JavaScript. Списки товаров на сайтах электронной коммерции, комментарии пользователей на социальных платформах и контент с бесконечной прокруткой обычно загружаются через вызовы AJAX, которые происходят через миллисекунды или секунды после загрузки страницы.

Такое несоответствие во времени приводит к тому, что вместо реальных данных скраперы извлекают элементы-заполнители, загрузочные спиннеры или пустые контейнеры. Соскобленный HTML может содержать <div class="product-list" data-loading="true"></div>, а не заполненную информацию о продукте.

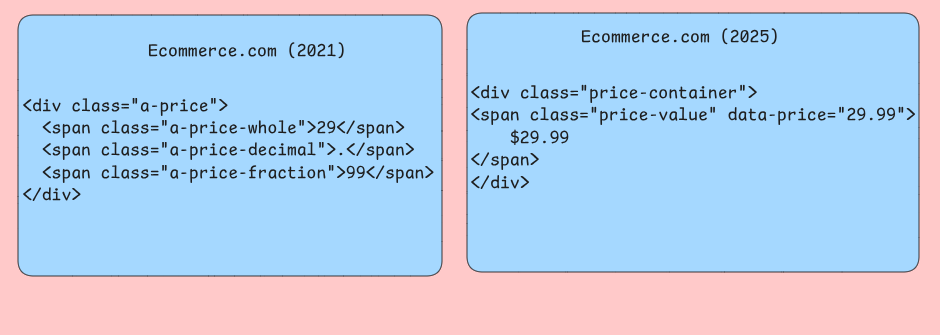

Непоследовательная эволюция структуры DOM

Веб-сайты часто изменяют свою структуру HTML, не поддерживая обратную совместимость для автоматизированных инструментов. У них могут быть селекторы CSS, которые надежно работали в течение нескольких месяцев и вдруг стали выдавать пустые результаты, когда разработчики изменили имена классов, перестроили макеты или переместили элементы в другие родительские контейнеры. Ваш скрапер может нацелиться на селекторы .product-price, которые переименовываются в .item-cost во время редизайна сайта.

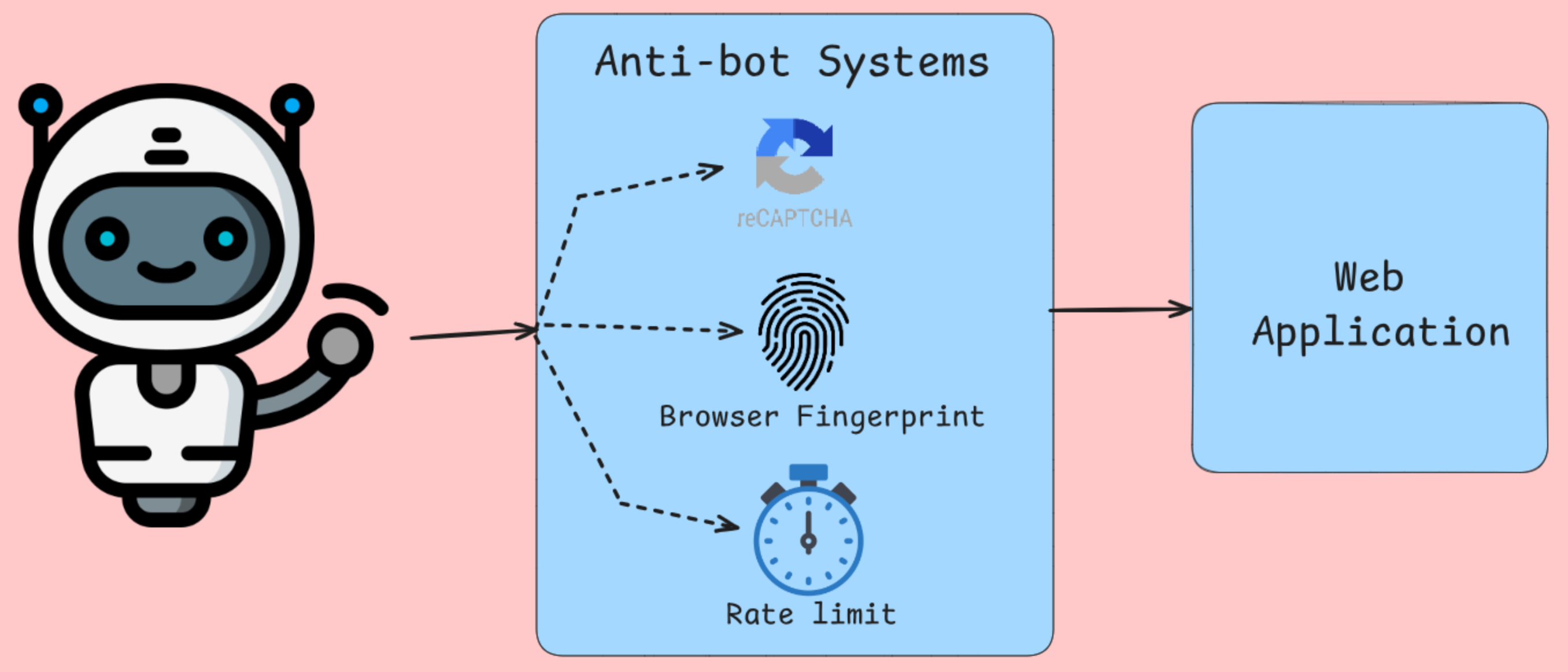

Системы защиты от ботов портят сбор данных

Системы обнаружения ботов не только блокируют IP-адреса, анализируют отпечатки пальцев браузера, движения мыши и другие хорошо известные проверки. Такие инструменты, как Cloudflare и подобные сервисы, внедряют JavaScript-задачи, требующие выполнения браузером. После проверки браузера вам будет предоставлен альтернативный контент или страницы ошибок для запросов, которые не прошли эти тесты. Вместо легитимного контента ваш крапер получает страницы CAPTCHA, сообщения об отказе в доступе или заведомо ложные данные.

Алгоритмы ограничения скорости отслеживают частоту запросов по IP-адресу, строке пользовательского агента и т. д. С помощью этой информации трафик дросселируется или блокируется, если он действительно похож на человеческую деятельность.

Проблемы рендеринга на стороне сервера

Рендеринг на сервере с помощью таких фреймворков, как Next.js, генерирует различные HTML-выводы на основе различных критериев. Один и тот же URL может возвращать совершенно разные структуры контента в зависимости от факторов, которые ваш скрапер не контролирует или не может точно смоделировать. Персонализированный контент, информация с географической привязкой и цены для конкретного пользователя создают сценарии, в которых ваш скрапер видит другие данные, чем предполагаемые пользователи.

Слои кэширования между вашим скрапером и исходными серверами создают временные несоответствия, когда недавно обновленному контенту требуется время, чтобы распространиться через узлы CDN. Ваш скрапер может получить неактуальные цены на товары, устаревшие уровни запасов или кэшированные страницы ошибок, которые не отражают текущее состояние сайта. Пограничные серверы в разных географических регионах могут предоставлять разные версии кэша, что делает согласованность данных зависимой от того, какой сервер отвечает на ваши запросы.

Повреждение данных на уровне сети

Нестабильные сетевые подключения, проблемы с прокси-серверами и разрешением DNS приводят к тонкому повреждению данных, которое трудно обнаружить с помощью стандартных методов обработки ошибок. Частичная загрузка контента создает усеченные HTML-ответы, которые успешно обрабатываются, но пропускают критические разделы страницы. Ваш скрапер может получить первые 80 % страницы с перечнем товаров и работать корректно, но при этом систематически пропускать элементы, загружаемые в нижней части длинных страниц.

Алгоритмы сжатия иногда повреждают данные во время передачи, особенно при использовании ротационных прокси с различными настройками сжатия.

Как влияют неточные данные на приложения?

Неточные данные Веб-скрейпинга влияют на системы таким образом, что в корне нарушают бизнес-логику и пользовательский опыт. Понимание этих проблем помогает разработчикам создавать более устойчивые конвейеры данных и слои проверки.

Деградация аналитического конвейера

Проблемы с качеством данных наиболее заметно проявляются в аналитических системах, где агрегирование усиливает основные ошибки. Когда в отсканированных данных о ценах электронной коммерции содержатся ошибки парсинга, преобразующие “$29,99” в “2999” из-за сбоев в обработке символов валют, расчеты средней цены становятся бессмысленными.

Соединения баз данных могут не работать без вашего ведома, если в идентификаторах товаров содержатся невидимые символы Юникода или пробельные символы. Система отслеживания товаров может отображать один и тот же товар в виде отдельных записей, что приводит к завышению количества запасов и искажению моделей прогнозирования спроса. Эти сбои в нормализации будут наблюдаться во всех процессах ETL, что приведет к удвоению доходов в последующих отчетах.

Сбои в работе систем принятия решений

Автоматизированные системы принятия решений, построенные на основе отбракованных данных, могут сделать катастрофически неверный выбор при ухудшении качества входных данных. Приложения для мониторинга цен, которые опираются на данные о конкурентах, взятые с динамических веб-сайтов, часто вместо реальных цен фиксируют значения-заполнители типа “Loading…” или сообщения об ошибках JavaScript. Когда эти нечисловые строки обходят уровни валидации, алгоритмы ценообразования могут по умолчанию принимать нулевые значения.

Если вы работаете над рекомендательными системами, они страдают от неполных наборов данных, в которых определенные категории товаров систематически не отражаются из-за проблем с пагинацией или препятствий для аутентификации. В результате перекоса рекомендаций в сторону успешно отсортированных категорий создаются эхо-камеры, которые снижают возможность ознакомления клиентов с различными продуктами, что в конечном итоге ограничивает рост доходов и удовлетворенность клиентов.

Снижение производительности приложений

Приложения, использующие отсканированные данные, испытывают проблемы с производительностью, когда проблемы с качеством данных приводят к неэффективным операциям с базой данных. Соскобленные текстовые поля, содержащие неэскэпированные HTML-теги, могут нарушать поисковую индексацию, вызывая полное сканирование таблицы вместо оптимизированного поиска в индексе. Функциональность поиска для пользователей становится невосприимчивой, когда эти проблемы с производительностью накапливаются при выполнении нескольких одновременных запросов.

Стратегии аннулирования кэша терпят неудачу, когда соскобленные данные содержат непоследовательное форматирование, делающее невозможным обнаружение дубликатов. Одна и та же информация о продукте, полученная в разное время, может отображаться как отдельные записи в кэше из-за разной обработки пробельных символов, что увеличивает расход памяти и снижает процент попадания в кэш. Такое загрязнение кэша вынуждает приложения выполнять повторные дорогостоящие вызовы базы данных, что снижает общую скорость отклика системы.

Проблемы интеграции данных

Скрапированные данные редко поступают изолированно. Обычно они объединяются с внутренними базами данных и сторонними API для создания комплексных наборов данных. Несоответствие схем становится обычным явлением, когда структура полей в отсканированных данных неожиданно меняется из-за редизайна сайта. Система каталога товаров может потерять критически важные характеристики, если логика соскабливания не сможет адаптироваться к новым макетам HTML, в результате чего последующие приложения получат неполную информацию о товарах, что повлияет на результаты поиска и решения о покупке.

Несоответствие свежести данных создает ситуацию, когда отсканированные данные отражают иные временные периоды, чем соответствующие внутренние данные. Финансовые приложения, объединяющие отсканированные рыночные данные с внутренними записями транзакций, могут выдавать неверные оценки портфеля, когда задержки при отсканировании приводят к тому, что информация о ценах отстает от временных меток транзакций. Такие временные несоответствия затрудняют создание точных путей аудита.

Различные способы повышения точности данных

Точность данных при веб-скрейпинге зависит от применения нескольких методов, которые работают вместе, чтобы устранить различные сбои в конвейере извлечения.

Работа с динамическим контентом с помощью безголовых браузеров

Традиционные скраперы на основе HTTP пропускают значительные порции данных, поскольку многие веб-сайты в значительной степени полагаются на JavaScript для отображения контента после первоначальной загрузки страницы. Безголовые браузеры, такие как Puppeteer или Playwright, выполняют JavaScript так же, как и обычные браузеры, обеспечивая захват всего динамически генерируемого контента.

Puppeteer обеспечивает контроль над рендерингом страниц благодаря интеграции протокола Chrome DevTools. Вы можете ждать завершения определенных сетевых запросов, следить за изменениями DOM и даже перехватывать вызовы API, которые наполняют страницу контентом. Такой подход особенно ценен для одностраничных приложений, которые загружают данные через AJAX-запросы после первоначального рендеринга.

При использовании безголовых браузеров отключайте изображения, CSS и ненужные плагины, чтобы уменьшить потребление памяти и улучшить время загрузки. Настройте размер области просмотра соответствующим образом, поскольку некоторые сайты отображают различный контент в зависимости от размеров экрана.

Быстро адаптируйтесь к изменениям структуры сайта

Структура сайтов часто меняется, что приводит к поломке скраперов, которые полагаются на фиксированные селекторы CSS или выражения XPath. Создание адаптивных скраперов требует внедрения стратегий отката и систем мониторинга, которые обнаруживают структурные изменения до того, как они приведут к потере данных.

Создавайте иерархии селекторов, которые пытаются использовать несколько подходов для поиска одного и того же элемента данных. Начните с самого специфичного селектора и постепенно переходите к более общим.

class AdaptiveSelector:

def __init__(self, selectors_list, element_name):

self.selectors = selectors_list

self.element_name = element_name

self.successful_index = 0

def extract_data(self, soup):

for i, selector in enumerate(self.selectors[self.successful_index:], self.successful_index):

elements = soup.select(selector)

if elements:

self.successful_index = i

return [elem.get_text(strip=True) for elem in elements]

raise ValueError(f "Не найден селектор для {self.element_name}")

# Использование

price_selector = AdaptiveSelector([

'div.price-current .price-value', # Наиболее специфичный

'.price-current', # Промежуточный

'[class*="price"]' # Широкий запасной вариант

], 'product_price')Реализуйте системы обнаружения изменений, которые сравнивают отпечатки структуры страницы с течением времени.

Валидация и очистка полученных данных

Необработанные данные содержат множество несоответствий, которые влияют на точность ваших данных. Чтобы исправить это, необходимо внедрить комплексный конвейер проверки и очистки. Это позволит превратить грязные веб-данные в надежные наборы данных, пригодные для последующей обработки.

Проверка данных начинается с проверки типа и формата. Цены должны соответствовать шаблонам валют, даты должны правильно анализироваться, а числовые поля должны содержать правильные числа.

импортировать re

from datetime import datetime

from typing import Optional, Dict, Any

class DataValidator:

def __init__(self):

self.patterns = {

'price': re.compile(r'[$€£¥]?[d,]+.?d*'),

'email': re.compile(r'^[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+.[a-zA-Z]{2,}$'),

'phone': re.compile(r'^+?[ds-()]{10,}$'),

'date': re.compile(r'd{4}-d{2}-d{2}|d{2}/d{2}/d{4}')

}

def validate_record(self, record: Dict[str, Any]) -> Dict[str, Any]:

cleaned_record = {}

for field, value in record.items():

if value is None or str(value).strip() == '':

cleaned_record[field] = None

продолжить

очищенное_значение = self._clean_field(field, str(value))

if self._is_valid_field(field, cleaned_value):

cleaned_record[field] = cleaned_value

else:

cleaned_record[field] = None

return cleaned_record

def _clean_field(self, field_name: str, value: str) -> str:

# Удаление лишних пробельных символов

cleaned = re.sub(r's+', ' ', value.strip())

# логика очистки

return cleaned

def _is_valid_field(self, field_name: str, value: str) -> bool:

if 'price' in field_name.lower():

return bool(self.patterns['price'].match(value))

elif 'email' in field_name.lower():

return bool(self.patterns['email'].match(value))

# Добавить дополнительные валидации для конкретных полей

return len(value) > 0Реализуйте обнаружение выбросов для выявления подозрительных точек данных, которые могут указывать на ошибки скрапинга. Такие статистические методы, как анализ интерквартильного размаха, помогут выявить цены, количество или другие числовые значения, которые выходят за пределы ожидаемых диапазонов. Алгоритмы сходства строк позволяют обнаружить поврежденные текстовые поля или ошибки извлечения.

Реализуйте обработку ошибок и повторные попытки

Сбои в работе сети, ошибки сервера и исключения при веб-скрейпинге неизбежны. Создание веб-скрапера с комплексной обработкой ошибок позволяет предотвратить каскадирование отдельных сбоев до полного отказа, а механизмы повторных попыток автоматически справляются с временными проблемами.

Экспоненциальная обратная задержка – эффективная стратегия для борьбы с ограничением скорости и временной перегрузкой сервера. Начните с коротких задержек и постепенно увеличивайте время ожидания для последующих попыток повтора. Такой подход дает серверам время на восстановление и при этом позволяет избежать агрессивных моделей повторных попыток, которые могут спровоцировать меры по борьбе с ботами.

импорт asyncio

import aiohttp

from typing import Optional, Callable

class ResilientScraper:

def __init__(self, max_attempts=3, base_delay=1.0):

self.max_attempts = max_attempts

self.base_delay = base_delay

self.session = None

async def fetch_with_retry(self, url: str, parse_func: Callable) -> Optional[Any]:

for attempt in range(self.max_attempts):

try:

if attempt > 0:

delay = self.base_delay * (2 ** attempt)

await asyncio.sleep(delay)

async с self.session.get(url) в качестве ответа:

if response.status == 200:

content = await response.text()

return parse_func(content)

elif response.status == 429: # Скорость ограничена

продолжить

elif response.status >= 500: # Ошибка сервера

продолжить

else: # Ошибка клиента

return None

except (aiohttp.ClientError, asyncio.TimeoutError):

продолжить

return NoneШаблоны автоматического отключения не позволяют скраперам перегружать отказывающие сервисы. Отслеживайте количество ошибок для отдельных доменов и временно отключайте запросы, если количество отказов превышает допустимый порог. Такой подход защитит и ваш скрапер, и целевой сайт от лишней нагрузки во время сбоев.

Используйте ротационные прокси и агенты пользователя

Блокировка IP-адресов – одно из самых распространенных препятствий на пути крупного Веб-скрейпинга. Ротационные прокси и агенты пользователя распределяют запросы между различными очевидными источниками, что значительно усложняет их обнаружение при сохранении скорости скраппинга.

Ротация прокси требует тщательного управления пулами соединений и распределением запросов. Избегайте использования одного и того же прокси для последовательных запросов к одному и тому же домену, так как этот шаблон можно обнаружить. Вместо этого применяйте алгоритмы круговой или случайной выборки, которые обеспечат равномерное распределение по пулу прокси.

импорт random

из typing import List, Dict, Optional

class ProxyRotator:

def __init__(self, прокси: List[str], user_agents: List[str]):

self.proxies = proxies

self.user_agents = user_agents

self.failed_proxies = set()

def get_next_proxy_and_headers(self) -> tuple[Optional[str], Dict[str, str]]:

available_proxies = [p for p in self.proxies if p not in self.failed_proxies]

if not available_proxies:

self.failed_proxies.clear()

available_proxies = self.proxies

прокси = random.choice(available_proxies)

user_agent = random.choice(self.user_agents)

заголовки = {

'User-Agent': user_agent,

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language': 'en-US,en;q=0.5',

'Connection': 'keep-alive'

}

return proxy, headers

def mark_proxy_failed(self, proxy: str):

self.failed_proxies.add(proxy)Ротация пользовательских агентов должна имитировать реалистичное распределение браузеров в данных веб-аналитики. Взвешивайте список пользовательских агентов в соответствии с реальной статистикой доли рынка, чтобы варианты Chrome появлялись чаще, чем менее распространенные браузеры. Включите мобильные пользовательские агенты для сайтов, которые предоставляют различный контент на мобильных устройствах.

Управление прокси на основе ИИ

При сборе данных запрет IP-адресов становится проблемой, которая может полностью остановить вашу работу. Например, если вы скрапите туристический сайт для поиска цен на авиабилеты, сайты легко обнаружат несколько запросов, поступающих с одного IP-адреса на высокой скорости, что позволит им легко отметить и запретить ваш скрапер.

Решение заключается в управлении прокси на основе ИИ, а не в простой ротации прокси. Этот подход использует пул прокси-серверов для распределения запросов по разным IP-адресам, эффективно маскируя вашу личность. Профессиональные сервисы, такие как Bright Data, предлагают доступ к более чем 150 миллионам резидентских IP из примерно 195 стран.

Интеллектуальное управление прокси обеспечивает несколько ключевых преимуществ. Оно обеспечивает анонимность, чтобы веб-сайты не могли отследить подозрительную активность непосредственно у вас, и реализует динамическое ограничение скорости, которое регулирует частоту запросов, имитируя поведение человека.

Совместная работа этих стратегий позволяет создавать скраперы, которые сохраняют точность данных в различных веб-средах. Безголовые браузеры захватывают полный контент, адаптивные селекторы обрабатывают структурные изменения, конвейеры проверки очищают извлеченные данные, комплексная обработка ошибок предотвращает сбои, а управление прокси на основе ИИ оптимизирует доставку.

Инструменты и лучшие практики для надежного скрапинга

Выбор подходящего инструмента для скрапинга зависит от сложности целевых веб-сайтов и требований к масштабируемости. В этом разделе рассматриваются четыре категории инструментов, которые решают различные технические задачи в области веб-скрейпинга.

Библиотеки Python для статического контента

Beautiful Soup отлично справляется с разбором HTML-документов, содержимое которых загружается непосредственно в первоначальном ответе сервера. Библиотека изящно справляется с деформированным HTML и предоставляет интуитивно понятные методы навигации для извлечения данных из вложенных элементов. Requests прекрасно сочетается с Beautiful Soup для работы со свойствами сайта, которые требуются многим сайтам для правильного доступа к данным.

Scrapy работает как полноценный фреймворк, а не как простая библиотека. Он управляет одновременными запросами с помощью встроенного планировщика и обрабатывает сложные сценарии краулинга с помощью своей конвейерной архитектуры. Вы можете использовать систему промежуточного ПО для обработки пользовательских запросов, ротации пользовательского агента и механизмов автоматического повтора.

Автоматизация браузеров для динамического контента

Selenium управляет реальными браузерами через протоколы WebDriver, что делает его подходящим для веб-сайтов, которые сильно зависят от выполнения JavaScript для визуализации контента. Инструмент обрабатывает такие действия пользователя, как отправка формы, нажатие кнопки и прокрутка страниц, которые вызывают дополнительную загрузку контента. Вам потребуется явно ввести условия ожидания, чтобы приостановить выполнение до тех пор, пока определенные элементы не станут доступны или не будут соответствовать определенным критериям.

Playwright предоставляет аналогичные возможности автоматизации браузера с улучшенными характеристиками производительности и встроенной обработкой современных веб-функций. Функция автоматического ожидания устраняет большинство проблем со временем, автоматически дожидаясь, пока элементы станут доступными для выполнения, прежде чем приступать к взаимодействию. Возможности сетевого перехвата Playwright позволяют отслеживать вызовы API, которые наполняют содержимое страницы, что часто позволяет выявить более эффективные методы доступа к данным, чем разбор HTML.

Решения для безголовых браузеров

Puppeteer специально нацелен на браузеры на базе Chromium и предлагает хороший контроль над поведением браузера благодаря интеграции с протоколом DevTools. Инструмент отлично справляется с созданием скриншотов, PDF-файлов и метрик производительности наряду с извлечением данных. В нем есть функция перехвата запросов, которую можно использовать для блокировки ненужных ресурсов, таких как изображения и таблицы стилей, и повышения скорости скраппинга для извлечения контента.

Кроссбраузерность Playwright делает его ценным инструментом для скраппинга на различных движках рендеринга. Функция codegen записывает взаимодействия пользователей и генерирует соответствующие сценарии автоматизации.

Платформы управления прокси для предприятий

Bright Data обеспечивает ротацию IP-адресов по всему миру с возможностью сохранения сеансов, что позволяет поддерживать постоянную идентификацию в течение сеансов скраппинга на нескольких страницах. Служба Web Unlocker автоматически обрабатывает общие меры по борьбе с ботами, включая решение CAPTCHA и рандомизацию отпечатков пальцев браузера. Браузер для скрейпинга сочетает в себе ротацию прокси с предварительно настроенными экземплярами браузера, оптимизированными для предотвращения обнаружения.

Управление запросами и ограничение скорости

Реализация стратегий обратного хода позволяет предотвратить перегрузку целевых серверов и в то же время изящно справляться с временными отказами. Например, urllib3, один из лучших HTTP-клиентов Python, предоставляет механизмы повторных попыток с настраиваемыми задержками между попытками. Пользовательское ограничение скорости с использованием алгоритмов “маркерного ведра” обеспечивает соответствие интервалов между запросами пропускной способности сервера, а не применение фиксированных задержек, которые могут быть как слишком агрессивными, так и недостаточными.

Управление сеансами может стать важным для веб-сайтов, требующих аутентификации или сохранения состояния при разных запросах. Постоянное хранение файлов cookie и управление заголовками обеспечивают скраперам доступ к защищенному контенту в течение длительных сеансов скрапинга. Пул соединений снижает накладные расходы за счет повторного использования установленных сетевых соединений при нескольких запросах к одному и тому же домену.

Валидация данных

Библиотеки проверки схем, такие как Pydantic, обеспечивают согласованность структуры данных и выявляют ошибки парсинга до того, как они распространятся по конвейерам обработки. Реализация проверки контрольных сумм для скрапированного контента помогает обнаружить, когда веб-сайты изменяют свою структуру или форматирование контента, вызывая предупреждения для обслуживания скраперов.

Выбор между этими инструментами зависит от ваших конкретных технических требований. Например, скраперы для статического контента обеспечивают максимальную производительность при выполнении простых задач извлечения, в то время как средства автоматизации браузера справляются со сложными интерактивными сценариями за счет повышенного потребления ресурсов.

Заключение

В этой статье мы узнали о проблемах, с которыми сталкиваются разработчики при извлечении данных с веб-сайтов, затем мы определили результаты некачественного извлечения. И наконец, мы узнали об инструментах и стратегиях, которые могут помочь вам решить эти проблемы.